Naviguer dans le monde de la DSPM pour l'IA et pourquoi elle est essentielle pour les entreprises

La sécurité de l'IA est devenue une nécessité commerciale. Alors que de plus en plus d'organisations utilisent l'IA dans leurs opérations quotidiennes, elles sont confrontées à des risques croissants liés aux données sensibles, à la conformité réglementaire et à la mauvaise utilisation des modèles.

Une approche efficace pour sécuriser rapidement ces environnements consiste à étendre les systèmes de gestion de la posture de sécurité des données (DSPM) existants pour couvrir tous les flux de travail d'IA.

Dans cet article, vous découvrirez pourquoi DSPM pour IA est si important, les capacités de base dont les entreprises ont besoin, la façon dont des solutions telles que Microsoft Purview évoluent pour répondre à la sécurité de l'IA, et bien plus encore.

Pourquoi la DSPM pour l'IA est essentielle en 2025

Selon un rapport de KPMG, 67 % des dirigeants ont l'intention de prévoir un budget pour les protections liées aux modèles d'IA. Ce changement montre que les dirigeants comprennent les nouveaux risques liés aux systèmes d'IA.

Voici les principales raisons pour lesquelles le renforcement Sécurité de l'IA via le DSPM devient une priorité absolue en 2025 :

Le défi de l'explosion des données de l'IA

Le volume et la variété des données (souvent non structurées) générées et consommées par les modèles d'IA sont impossibles à surveiller et à gérer avec les outils de sécurité classiques. De plus, ces ensembles de données peuvent contenir des informations sensibles.

Sans visibilité sur l'emplacement de ces données ni sur la manière dont elles sont accessibles, les entreprises sont confrontées à un risque accru de fuite ou d'utilisation abusive.

L'IA fantôme et l'exposition incontrôlée des données

Poussés par le désir d'être plus efficaces, les employés peuvent utiliser des outils d'IA non surveillés et non autorisés, créant ainsi »IA fantôme. » Ce faisant, ils peuvent saisir à leur insu des données propriétaires ou réglementées dans des systèmes d'IA. L'IA fantôme crée des angles morts pour vos équipes de sécurité.

DSPM for AI comble ces lacunes en étendant la découverte et la surveillance aux flux de travail d'IA.

Pression réglementaire et lacunes en matière de conformité

Pour gérer correctement les risques liés à l'IA, les régulateurs créent de nouvelles règles en matière de confidentialité et de sécurité des données. De nombreuses organisations ont du mal à suivre le rythme, en particulier lorsque leurs stratégies DSPM ont été conçues uniquement pour les environnements de données traditionnels.

La DSPM pour l'IA comble cette lacune en faisant correspondre les exigences de conformité directement aux flux de travail de l'IA, aidant ainsi les organisations à adhérer à des cadres tels que Loi sur l'IA de l'UE, Cadre de gestion des risques liés à l'IA du NIST, RGPD et HIPAA.

Risques liés aux données d'entraînement des modèles d'IA

Les données utilisées pour entraîner les modèles d'IA constituent une cible de grande valeur pour les cybercriminels et une source majeure de risques internes. Si des informations personnelles identifiables (PII) ou des données commerciales confidentielles sont incluses dans les kits de formation, cela peut entraîner des violations de la conformité, une atteinte à la réputation et même des attaques d'empoisonnement des modèles.

DPSM for AI réduit ces risques en analysant les ensembles de données d'entraînement, en classant les informations sensibles et en mettant en place des garde-fous avant que les données ne soient ingérées dans les modèles d'IA.

DSPM de base pour les capacités d'IA dont les organisations ont besoin

Lors de la mise en place d'un DSPM pour une stratégie d'IA, certaines fonctionnalités ne sont pas négociables. Il s'agit notamment de :

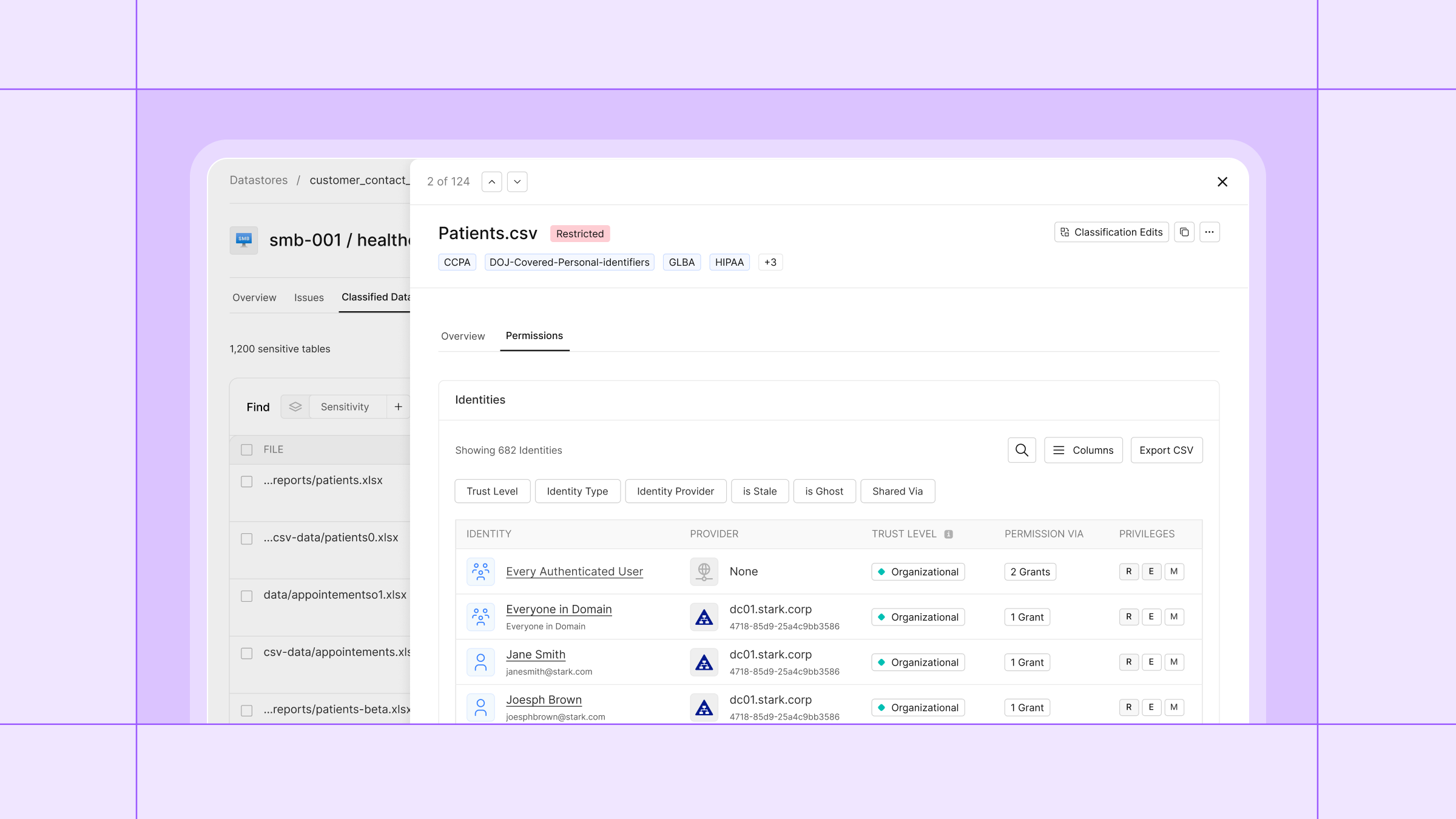

Découverte et classification des données basées sur l'IA

Contrairement aux outils de découverte traditionnels qui analysent des bases de données structurées, DSPM for AI doit comprendre les données uniques utilisées pour la formation et l'inférence.

Cela signifie qu'il doit :

- Identifiez les informations sensibles dans des ensembles de données structurés, semi-structurés et non structurés.

- Classez les données à l'aide de balises contextuelles telles que propriétaire, objectif, impact réglementaire, et sensibilité.

- Détectez des combinaisons d'ensembles de données apparemment inoffensifs qui pourraient créer des problèmes de conformité en cas de fusion.

- Atteignez une précision élevée pour minimiser les faux positifs et réduire le bruit pour les équipes de sécurité.

Surveillance des interactions avec l'IA en temps réel

Les systèmes d'IA traitent les données différemment des applications traditionnelles. Sans visibilité sur les entrées et les sorties, des données sensibles peuvent être exposées par le biais d'invites ou de réponses.

Un DSPM efficace pour l'IA devrait :

- Suivez les requêtes des utilisateurs et les résultats générés par l'IA en temps réel.

- Détectez quand des informations réglementées ou sensibles sont saisies dans les invites.

- Signaler les tentatives d'extraction de données confidentielles à partir de modèles (par exemple, injection rapide).

Application automatique des politiques pour les charges de travail liées à l'IA

La supervision manuelle n'est pas suffisante à grande échelle. Le DSPM pour l'IA devrait appliquer automatiquement des règles qui s'alignent sur les politiques de gouvernance :

- Définissez quelles données peuvent ou ne peuvent pas être utilisées pour l'entraînement et l'inférence.

- Intégrez les contrôles existants tels que DLP, IAM et SIEM pour étendre la sécurité à l'ensemble de la pile.

- Appliquez un accès avec le moindre privilège aux ensembles de données et aux environnements d'IA.

Cartographie et rapports de conformité

Les auditeurs et les régulateurs exigeront de plus en plus de preuves d'une utilisation sûre de l'IA.

Les outils DSPM pour IA doivent être capables de :

- Générez des pistes d'audit reliant les ensembles de données aux modèles qu'ils entraînent.

- Afficher les contrôles en place pour empêcher tout accès non autorisé ou toute utilisation abusive.

- Produisez des rapports de conformité conformes au RGPD, au CCPA, à l'HIPAA, à la PCI DSS, à la SOC 2, au RMF NIST AI et aux réglementations émergentes en matière d'IA.

Microsoft Purview DSPM pour l'IA : fonctionnalités et limites

Microsoft Purview a étendu ses fonctionnalités DSPM à l'IA, ce qui en fait un choix naturel pour les équipes qui utilisent déjà Microsoft 365 et Azure.

Points forts de l'intégration native de Microsoft 365

Les principaux points forts sont les suivants :

- Fournit une visibilité sur les activités d'IA, en particulier pour Microsoft 365 Copilot, les agents et d'autres outils d'IA internes.

- Propose des politiques prêtes à l'emploi, qui permettent aux administrateurs d'activer rapidement les protections sans avoir à tout créer à partir de zéro.

- Idéal pour les flux de travail centrés sur Microsoft car il fonctionne avec Microsoft Security Copilot, la protection des informations, la gestion des risques internes, la DLP, etc.

Lacunes de couverture et limites de l'entreprise

Purview s'en sort très bien, mais vous devez tenir compte de certaines limites et de certaines lacunes :

- Pureview a une visibilité limitée en dehors de la gamme Microsoft, ce qui signifie que des intégrations supplémentaires peuvent être nécessaires pour une couverture supplémentaire.

- Peut rencontrer des difficultés avec divers types de fichiers, systèmes multimédias ou systèmes de stockage qui ne sont pas entièrement connectés à ses outils de numérisation, ce qui rend la classification moins précise.

Risques et surveillance liés aux plateformes d'IA tierces

Une stratégie DSPM complète pour l'IA doit aller au-delà des systèmes internes. Il doit tenir compte de la manière dont les employés et les unités commerciales interagissent avec les plateformes d'IA externes, souvent sans approbation informatique ou de sécurité. Ces services tiers présentent de sérieux risques s'ils ne sont pas surveillés et ne sont pas gérés.

Suivi de l'utilisation de ChatGPT par les entreprises et les consommateurs

La frontière entre la vie personnelle et professionnelle d'un utilisateur s'estompe lorsqu'il s'agit d'outils tels que ChatGPT. Même lorsque les employés ont accès à ChatGPT Enterprise, ils peuvent saisir sans le savoir des données sensibles de l'entreprise sur leur compte personnel.

Pour faire face à ce risque, une stratégie DSPM pour l'IA devrait :

- Détectez quand des données sensibles sont saisies dans les invites, même avec un compte d'entreprise.

- Surveillez les réponses pour identifier les cas où les sorties peuvent contenir des données partagées ou exclusives.

- Appliquez des contrôles automatisés lorsqu'un comportement dangereux est détecté.

Google Bard, Claude et les plateformes d'IA émergentes

Au-delà des LLM bien connus, de nombreuses entreprises adoptent des applications d'IA plus petites et spécifiques à leur secteur d'activité.

L'extension du DSPM à ces plateformes signifie :

- Analyse des connexions et du trafic d'API liés à des services d'IA non autorisés.

- Signaler les flux de données inhabituels qui suggèrent que des informations sensibles sont envoyées de l'extérieur.

- Appliquer des politiques cohérentes sur toutes les plateformes, et pas seulement sur les « grands noms ».

- Donner au service informatique et à la sécurité une visibilité sur les personnes qui expérimentent de nouveaux outils et sur les données qu'elles traitent.

Applications d'IA spécifiques à l'industrie

Dans de nombreux cas, les données les plus risquées ne circulent pas via des chatbots à usage général, mais via des applications d'IA spécifiques au secteur, telles que :

- L'IA du secteur de la santé analyse les dossiers médicaux des patients.

- IA financière utilisant des modèles de notation de crédit ou de détection des fraudes.

- L'IA industrielle traite les données des capteurs IoT provenant d'infrastructures critiques.

Une stratégie DSPM complète pour l'IA doit s'étendre à ces environnements spécialisés en cartographiant les pipelines de données à travers des modèles spécifiques à l'industrie et en appliquant des garde-fous en fonction des spécificités du secteur conformité cadres.

Conclusion

Entreprise Initiatives d'IA ne peuvent réussir que s'ils reposent sur la sécurité et la confiance. En l'absence de mesures de protection appropriées, des données sensibles peuvent être exposées, les obligations de conformité peuvent être ignorées et les modèles peuvent être exposés à une utilisation abusive.

La DSPM pour l'IA répond à ces défis en offrant aux organisations la visibilité et la gouvernance nécessaires pour gérer efficacement les risques liés aux données. En plaçant la DSPM au cœur de leur stratégie d'IA, les entreprises peuvent accélérer l'adoption tout en garantissant la sécurité, la conformité et la durabilité de l'innovation.

FAQs

Qu'est-ce que le DSPM pour l'IA ?

La DSPM pour l'IA consiste à appliquer les principes de la DSPM, tels que la découverte des données, la classification et la surveillance de la conformité, aux systèmes d'IA. Cela implique :

- Suivi de la façon dont les données sensibles circulent dans les environnements de formation, d'inférence et de stockage.

- Détecter les projets d'IA parallèle susceptibles de fonctionner en dehors de la gouvernance officielle.

- Imposer l'accès au moindre privilège pour les développeurs, les data scientists et les opérateurs d'IA.

En quoi le DSPM pour IA diffère-t-il du DSPM classique ?

Le DSPM régulier se concentre sur les données au repos, surveille les actifs de données généraux pour détecter les failles de sécurité et garantit la conformité. Le DSPM pour l'IA s'appuie sur cela pour relever les défis spécifiques à l'IA en :

- Gestion des ensembles de données utilisés dans la formation et l'inférence de l'IA, qui peuvent être volumineux, non structurés ou sensibles.

- Surveillance de l'utilisation, de l'accès et des abus potentiels des modèles d'IA.

- Fournir une évaluation continue des flux de travail d'IA plutôt que de se limiter à des actifs de données statiques.

Microsoft Purview DSPM for AI est-il suffisant pour répondre aux besoins des entreprises ?

La réponse courte est : cela dépend. Le DSPM pour l'IA de Purview offre de solides fonctionnalités, en particulier dans les environnements où Microsoft est omniprésent. Cependant, pour les entreprises ayant des besoins complexes, multicloud ou hybrides en matière d'IA, il se peut qu'elle ne couvre pas tout d'abord.

Obtenez une visibilité complète

avec notre évaluation des risques liés aux données.