Les 5 principales lacunes de sécurité des données d'IA générative dans les environnements d'entreprise - et comment les corriger

Toutes les entreprises le disent, mais cette fois, c’est vraiment vrai. L’IA générative (GenAI) redéfinit la façon dont les entreprises fonctionnent, innovent et se concurrencent. Mais elle apporte aussi un ensemble de risques nouveaux et en constante évolution – en particulier en ce qui concerne les données qui alimentent ces systèmes. La plupart des entreprises ont adopté la GenAI plus rapidement que leurs stratégies de sécurité et de conformité n’ont pu suivre, créant ainsi des vulnérabilités invisibles qui pourraient entraîner des violations réglementaires, une exposition de la propriété intellectuelle ou des fuites publiques.

Voici les cinq principaux angles morts liés aux risques de l’IA que nous observons dans les centaines d’environnements d’entreprise que nous accompagnons aujourd’hui – et comment vous pouvez les corriger.

1. Vous ne savez pas où se trouvent vos données sensibles

Vous ne pouvez pas protéger ce que vous ne voyez pas. À mesure que les LLM consomment de plus en plus de données, la plupart des équipes n'ont toujours pas d'inventaire clair de ce qui est ingéré—ni si ces données sont réglementées, sensibles ou propriétaires. C'est ainsi que les fuites se produisent. L'IA fantôme aggrave encore la situation, avec des outils comme Copilot et ChatGPT qui intègrent discrètement des données dans des flux de travail non autorisés.

Corrigez-le :

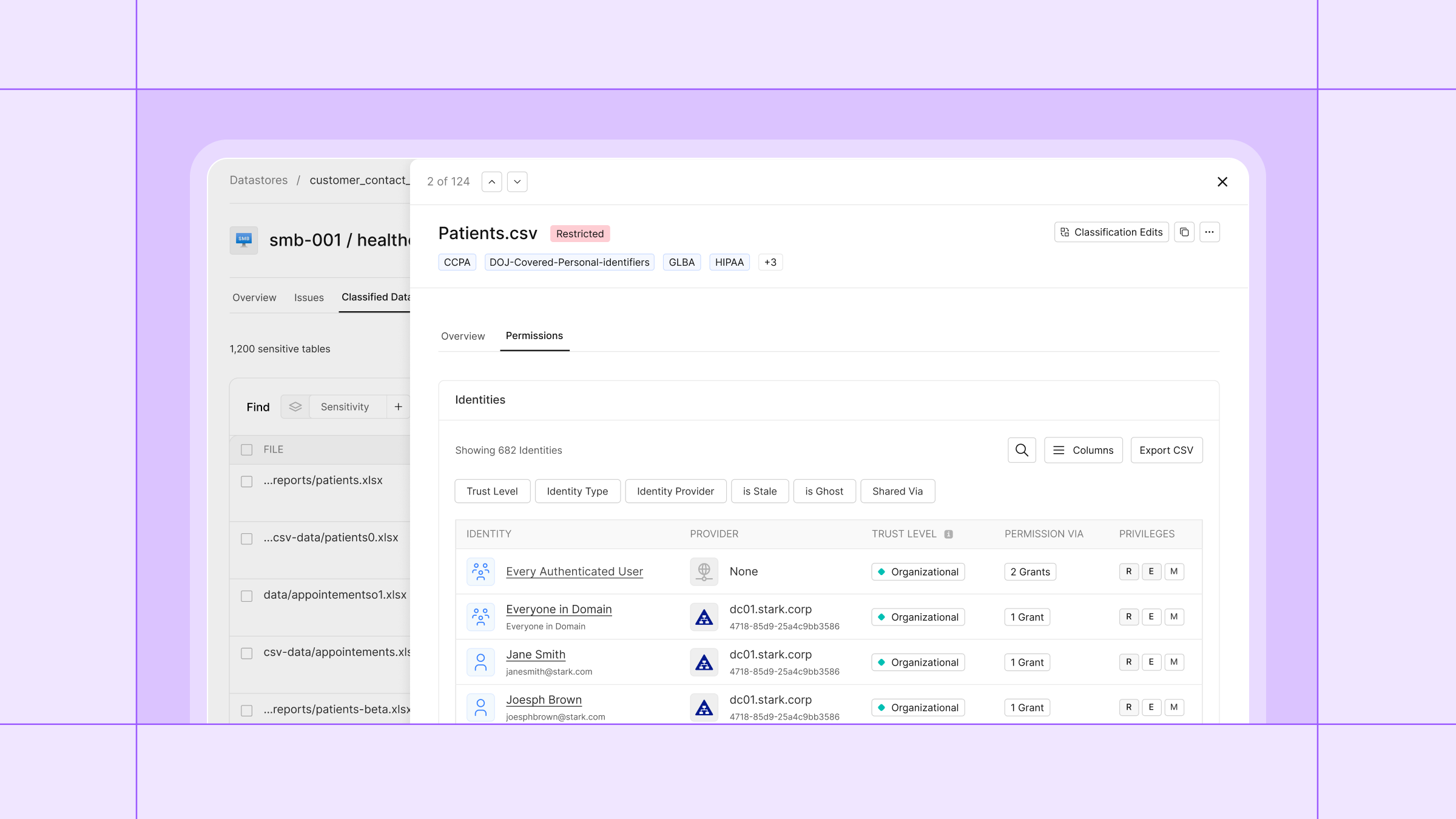

Commencez par la visibilité. Cyera découvre et classe automatiquement les données sensibles dans vos environnements cloud, SaaS et non structurés, sans agents ni étiquetage manuel. Il vous fournit une cartographie en temps réel de ce que vous possédez, de l’emplacement de vos données et de leur utilisation, afin que vous puissiez garder le contrôle avant que les données ne se retrouvent au mauvais endroit. Recherchez l’étiquetage automatisé, la cartographie de l’origine des données et l’évaluation de la sensibilité pour constituer un inventaire complet et en temps réel de vos données.

2. Accès excessif de l'IA aux données

L’IA n’est sûre que dans la mesure des accès qui lui sont accordés. Les copilotes, comptes de service et rôles utilisateurs sont souvent sur-autorisés, surtout dans des environnements en évolution rapide. C’est ainsi que des données sensibles peuvent être exposées ou accidentellement intégrées dans des ensembles d’entraînement, des journaux ou du contenu généré.

Corrigez-le :

Vous avez besoin d'un moyen de lier les identités aux données qu'elles utilisent réellement. Chez Cyera, nous y parvenons grâce à notre Module d'Accès aux Identités (nous n'aimons pas trop ce nom, donc si vous en avez un meilleur, n'hésitez pas à me contacter !). Nous mettons en évidence les combinaisons d'accès toxiques, signalons les identités dormantes avec des droits excessifs, et vous aidons à appliquer le principe du moindre privilège en fonction du contexte. C'est ainsi que vous optimisez l'accès à grande échelle—avant qu'il ne se transforme en violation de données.

3. Absence de garde-fous pour l'utilisation des données par l'IA

Des politiques sans application ne sont que des vœux pieux. La plupart des organisations n'ont pas défini quelles données les LLM peuvent consulter, et encore moins mis en place des contrôles pour empêcher une utilisation risquée en temps réel. C'est la recette idéale pour une fuite de données, surtout avec des outils qui conservent l'historique ou acheminent le trafic vers l'extérieur.

Réparez-le :

Cyera applique des politiques tenant compte de l’IA qui contrôlent quelles données peuvent être utilisées, comment et par qui. Nous vous aidons à appliquer des règles de manière dynamique—par exemple, en bloquant les requêtes sensibles vers des LLM internes ou en caviardant les données réglementées lors des interactions avec Copilot. Adaptez les contrôles à l’application et au niveau de risque.

4. Manque de visibilité sur les flux de travail d'IA

Vous ne pouvez pas sécuriser l'IA si vous ne comprenez pas comment elle utilise vos données. La plupart des équipes n'ont aucune visibilité sur la façon dont les copilotes, les modèles internes ou les outils tiers interagissent avec des informations sensibles. Cela laisse une lacune massive dans votre stratégie de détection et de réponse.

Réparez-le :

Cyera vous offre une visibilité continue sur les flux de données pilotés par l’IA. Nous suivons les entrées de prompts, les sorties des modèles et les données qui les alimentent, afin que vous puissiez détecter les comportements à risque, auditer l’utilisation et réagir en temps réel. Fini de naviguer à l’aveugle. Astuce : choisissez des solutions de sécurité des données dotées de métadonnées spécifiques à l’IA et de pistes d’audit pour détecter presque en temps réel les schémas d’utilisation anormaux et les flux de données non autorisés.

5. La conformité ne suit pas le rythme de l'adoption de l'IA

Les réglementations n'ont pas changé, mais votre profil de risque a évolué. RGPD, HIPAA, CPRA—elles s'appliquent toujours, même lorsque les données circulent via l'IA. La plupart des équipes ne peuvent pas prouver comment les données réglementées sont utilisées dans les contextes d'IA, et les audits manuels ne peuvent pas suivre le rythme.

Réparez-le :

Cyera cartographie automatiquement les données sensibles selon les exigences réglementaires et signale lorsqu'elles sont utilisées de manière inappropriée. Nous vous aidons à prouver votre conformité à grande échelle et à éviter les surprises coûteuses lors des audits. C'est une conformité proactive, pas une gestion de crise. Recherchez des fonctionnalités comme les modèles de politiques par réglementation, la découverte automatisée des flux de données non conformes (par exemple, les données de citoyens européens qui migrent vers des modèles hébergés aux États-Unis) et des rapports prêts pour les audits. Vous devriez signaler de manière proactive les violations - avant que les régulateurs ou les clients ne le fassent !

Au final... La sécurité de l'IA commence par la sécurité des données

Plus les entreprises adoptent l’IA rapidement, plus il devient essentiel de sécuriser la base sur laquelle elle repose : les données. Les plateformes de sécurité des données ne sont pas une simple case à cocher — elles sont une condition préalable à une adoption sûre, évolutive et conforme de la GenAI au sein des entreprises aujourd’hui.

Chez Cyera, nous aidons les organisations à éliminer ces lacunes en matière de risques liés aux données, grâce à une visibilité en temps réel, des contrôles automatisés et une application tenant compte des identités qui évolue avec vos données.

Découvrez la plateforme et constatez par vous-même

Obtenez une visibilité complète

avec notre évaluation des risques liés aux données.